車両型ロボット アース・ローバー01の製作日誌 その2

製作の区切りごとに、新しい物から古い物の順に書いてあります。

2010.11.14

視覚とGPS機能の統合(屋外テスト)

先週作ったプログラムの機能を、外でアースローバーを走らせながらテストしました。

視覚の機能とGPSの機能で、使っているファイル番号が衝突していたところや、画像認識の結果

一度バックしてからでないと行けない場所だと分かった時の処理などを、若干のバグフィックス

の後、とりあえず動くようになりました。

「確実に動くようにする」という観点からは作り込みの余地が大いにあるのですが、実用に供するという

わけでもないのでひとまずこのテーマはココまでとして、次のテーマに移ろうかと思います。

次のテーマとしては、パターン認識機能の強化、視覚を利用したロボット周囲の3Dモデル作成機能(空間認識機能の強化)、

「道」の認識、オプティカルフローを応用した

動体認識に関する機能の実装・・・あたりを考えています。

2010.11.07

視覚とGPS機能の統合

ウェイポイントに置いた赤コーンを巡回する時に、載せているGPSユニットの精度不足

を補う形で視覚機能を利用できるように、ソフトウェアの機能を統合しました。

統合するにあたって、具体的には下記の作業を実施しました。

RCサーボのキャリブレーション

センサーヘッドを動かしつつ、ステレオマッチングによる測定を行う場合、センサーヘッドの

指向の正確さが誘導の正確さに利いてくるので、プログラム中から角度指定でセンサーヘッドを

動かしたときにその角度となる様、角度とPWMパルス幅の関係をとる係数を調整しました。

(ついでに調整作業の効率アップのためGUIも整備しました。)

視覚関連クラスの整備

w7b2側で、視覚フォームのボタンのコードに含まれている機能を、GPS誘導のフォームからも

利用できるよう、ボタンから切り離したコードにしつつ、変数のスコープを変えたりしました。

GPS誘導機能への視覚誘導機能埋め込み

GPSを利用して、ウェイポイントを辿るコードの途中、目的地に着いたか判断する部分に、

先日試した、「赤コーンにタッチする」機能を埋め込みました。具体的には、目的地到着したと

判断する、現在位置と目標座標の差を緩くし、GPSで到着判定が出た後で視覚誘導の機能に切り替わるようにしました。

2010.10.12

「赤コーンタッチ」の総合テスト(その2)

2010/09/25の結果をうけて、旋回制御の精度を上げて試してみました。今度は

4回トライして、4回ともタッチ成功でした。

前回までは、直径約2mで旋回するようにステアリングし、1周は車輪のエンコーダで

65カウント程度でした。よって精度としては360度÷65=5.53度で±5.53度の

誤差があり、コーンの3m手前で画像計測すると3m×tan5.53度≒0.3mでほぼ

車幅分の誤差が出ていました。

今回は、直径約4mで旋回するようにステアリングし、1周は車輪のエンコーダで

130カウント程度でした。よって精度としては360度÷130=2.77度で±2.77度の

誤差となり、触覚が触れる範囲になりました。

−−>

−−>

−−>

−−>

アプローチの過程の認識結果画像

アプローチ完了時の画面

2010.10.03

w7b.vbの整備

いつもプログラムをdebugモードで動かしているため、画像認識や移動制御のパラメータの

設定値については、ソースコードを直接変えながらロボットを動かしていたのですが、

最近全体的にコードを整理しているついでで、便利なように、前回の値をファイルに保持して次回実行に

つながるように変えました。

その他、少しずつ、動かしてテストしながら大きくしてきたプログラムなので、いきあたり

ばったりな感じで、変数に関して、フォーム間に変な依存関係などが出来てしまっていたりする

あたりも、別途グローバル変数的に利用するクラスを作って整理しました。

視覚関係の機能追加に併せて、GPSの入力をベースとして移動する機能の動作確認をせずに、

だいぶ移動関係のコードをいじったので、GPS関係の機能が死んでいないか確認するため

、久しぶりにGPSベースの野外走行テストをしました。予想に反して特に問題ありませんでした。

2010.09.25

「赤コーンタッチ」の総合テスト

赤コーンの測距機能と移動制御機能がつながったので、外で動かしてみました。

5m程離れて、コーンを認識できている状態から試してみました。3回試して3回とも

車幅程度のずれでタッチできずに空振りでしたが、移動制御プログラムのチューニングで、

旋回角度をより

正確にできる余裕がまだまだあるので、とりあえず目標達成かな?と思いました。

アプローチの結果

カメラ光軸キャリブレーション

2010.09.12の検討で、だいた50m以上はなれた場所が、左右のカメラでスクリーン上の

同じ座標に見えれば光軸は平行になっているとみなせることが分かったので、50m以上はなれた

場所の電柱など、分かり易いものがイメージの中心付近にあるイメージを撮影し、キャリブレーション

用のオフセット値を調べました。左のカメラを基準とすると、右のカメラのイメージは

水平方向に7ピクセル(約1.28度)、垂直方向に8ピクセル(約1.45度)のずれがありました。

水平方向のオフセット値を

3角測量計算に、水平方向のオフセットをエピポーラ線に反映させたところ、

まっすぐな壁が、見た目まっすぐに測定できるようになったようなので、測定結果が

だいぶ理論値に近づいたように感じました。

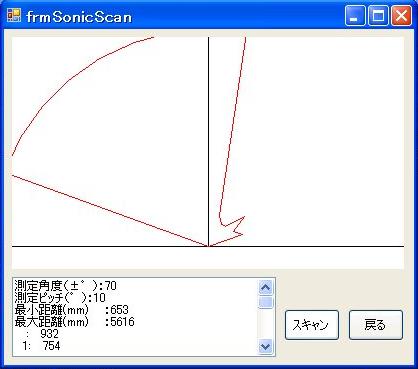

スキャン計測

2010.09.19

移動機能関連クラスの整備

2010.09.12

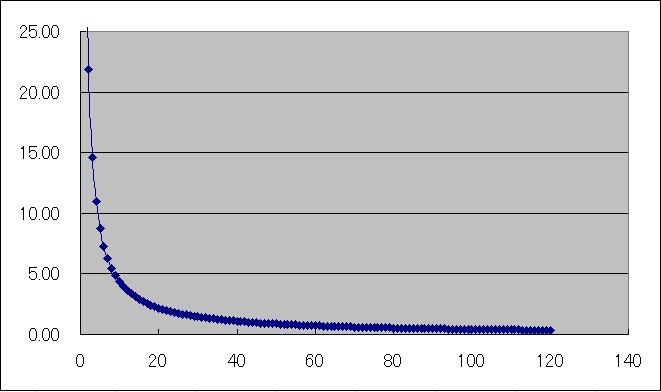

測距精度の検討

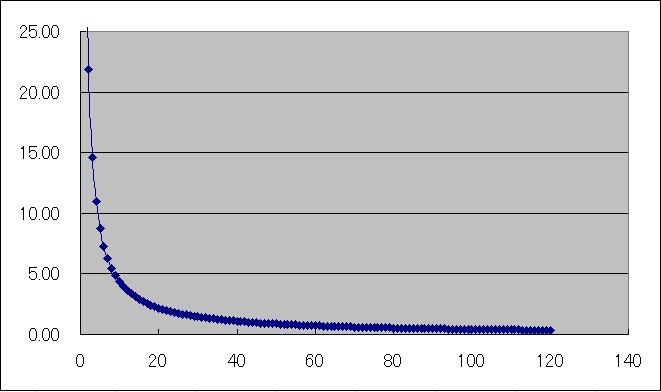

計算上でどの程度の測距精度があるのか、視差ピクセル数を横軸に、その時の距離を縦軸に

グラフを描いてみました。

視差ピクセル数−測定距離グラフ(画像サイズ320×240、カメラ間距離140mm)

最大測定距離のときは、視差が1ピクセルの時の測定値が44m、2ピクセルの時が22mだった

ので、分解能は

22mです。そう考えてグラフを解釈すると、カメラの光軸のずれだけでも数ピクセル以上

あるので、今のアースローバーの装置構成では、測定結果を信じていいのは3m程度まで

なのか〜と思い、先日の屋外テストの結果に納得しました。

Webで資料をいろいろ読んでみると、「カメラ間距離の10倍程度まで」が一般的に

精度良く測定できる実用的な測定範囲・・・らしいです。

面積相関のステレオマッチング(スキャン計測)

移動時の障害物検知用としての可能性を見るため、先週のプログラムを発展させて、水平方向に、8ピクセル跳びに検査窓を移動させて測定する機能を加えました。

スキャン計測

スクリーンハードコピーの下側にあるグラフ中で赤い丸が測定できた点で、縦軸の

目盛りは500mmです。1スキャンに40秒近くかかりました。並列計算に適した

アプリケーションの様に思えると共に、高速化したいと思ったので、CUDAを使って

、どれくらい早くできるか試してみたいと思いました。

2010.09.07

面積相関のステレオマッチング

9/5の更新に含めようと思ったのですが、YouTubeへのaviファイルのアップロードが

うまく行かず2日ずれました。(wmvはOKでした。)

下の動画では、イメージの中で水色の四角で囲んである部分が面積相関の計算を行っている

場所です。結果はウインドー左下の白いグラフエリアの赤丸と、隣のテキストボックスに

X,Y,Zの座標(ロボットの2台のカメラの中間が座標原点)で表示されます。

2010.09.05

面積相関のステレオマッチング

いままで実装していたのは特徴点を利用したステレオマッチングの手法でしたが、

最近、W6のステレオビジョンの実験に関して頂いた質問をきっかけに、面積相関を

計算してステレオマッチングする手法で沢山Webで見られる文献があり、応用製品も多く出ている

ことに今更ながら気がつきました。そこで、アースローバーにも実装してみることにしました。

はじめは実行速度よりも、プログラムの動きの分かり易すさを重視して、vbで書いてみました。

機能としては、左の画像をクリックすると、右の画像から同じ場所を面積相関の計算で探し、

マッチングできた場所を三角測量で位置を割り出すというものです。

シーンによってマッチングがうまくいったり、いかなかったり・・・基本的には

ロボットの周囲の障害物検知に使えそうですが、チューニングが難しそうだと思いました。

でもまあ、レーザーレンジファインダと比べると、ハードが安価なので、これはこれで

いいかもしれないとも思いました。

チューニングといえば、左右のカメラの光軸のずれが気になります。

手作りのプラ板の箱にマウントしているので、あまりどうこう出来るとも思えませんが、

出来るだけ調整してみるつもりです。

2010.08.29

測距機能のデバグ&調整

W6由来の関数で、W6のカメラ(128×128モノクロ)を前提として書いてある部分が

残っているのを探して直したり、一連の関数で配列変数の確保数にばらつきがあり

ランタイムエラーが出る場合があるなど、各所に残る考慮不足な部分を直したりしました。

今週も野外テストをしましたが、先週よりはだいぶ良くなりました。コーンがフレームから

はみ出るほど近づいた時の考慮が無いことに気がついたので、こういう類をトラップするコードも

加えました。

今日もとても暑く、ロボットの中はすぐに40度弱まで上がり、手に持って歩いていた

ネットブックの黒いキーボードも太陽熱で「あちっ」な感じでしたが、特に問題なく

テストは出来ました。

2010.08.22

赤コーンの測距機能(野外テスト)

移動制御のプログラムとの統合が半分程度終わったので、試しに外で動かしてみました。

テスト中の画面

いちおう動作したので、仕組み的には使えそうだと思いました。しかし、測定距離が

長くなるに従い誤差がとても大きくなってくる(実際2mのものが3mと出る程度)ことが分かった

ので、要因を一つづつ確認して改善しようと思いました。

2010.08.15

赤コーンの測距機能

「赤いコーン」というか、予め登録してある色のものについて、ステレオビジョンの画像を

利用して距離を測る機能を製作中です。色で2値化→ノイズ除去→インデックス付け等の

画像処理を経た結果について、左右の画像でマッチングを行い、距離を出すところまで作りました。

テスト中のスナップ

部屋が狭いので、アースローバーを床に置くとけっこう邪魔です。

テスト中の画面

約600mm離れた場所にポテトチップの円筒形の赤いパッケージを置いてテストしました。

dos窓の一番下の行に測定結果が出ています。622mmの距離で、パッケージの幅(筒の太さ)

は57.7mmとでています。(実際は約66mm)W6と比べて、意外と良い数字が出たなーと思いました。

カメラ特性計測用画像

視野の広さと像のレンズの歪みを見るため、約30cmの距離からカッターマットを撮影しました。

「歪みはそれほどでもないか?」

と感じたので、とりあえずOpenCVのレンズゆがみ補正はかけずにおくこととしました。下記の機能を

作ってひととおりデータを取った後で、どれくらい改善するのか、補正をかけて同じ事を

してみようと思います。

このあとは移動制御のプログラムとの統合を行います。具体的には、GPSを利用して指定の経路を

走行する途中でコーンを探し、見つけたらコーンの緯度経度を記録する機能と、予め緯度経度を

登録しておいた場所にコーンを置き、コーンにタッチするまでの精密アプローチを画像利用で行う

機能を作ろうと思っています。

2010.08.08

制御ソフトのコードの整理

新しいセンサーヘッドが完成して、カメラを2個うまくセット出来ました。そこで次は、ステレオ撮影

した画像から赤いコーンを探し、測距する機能を実装しようと思います。

手始めにW6で作ったソフトのコードを見て、以前のロジックを思い出しつつ新しいフローを考えました。

機能追加の作業準備と記憶を新たにするため、アースローバーのコードから既に用済みとなったコードを

消去する作業をしました。

2010.07.25

GPS−52を試してみる

センサーヘッド交換

ロジクールのC500を2個内蔵したセンサーヘッドを作りました。ケースを外して内蔵したので、

今までのよりも小さくなりました。(カメラ間の距離は同じです)

製作中のスナップ

新センサーヘッドで記念写真

2010.07.11

カメラ(ロジクールC500)のケース外し

GPSユニット交換

以前買って置いてあった秋月のGPS−52のキットを組んで載せました。

いつも使っているeTrexHよりもだいぶ精度が低そうなので、今となっては

あまり使いたい気が起きませんでしたが、使わずに捨ててしまうのがもったいなかったので、

eTrexHとの比較用データでも取ろうかと載せてみました。

GPS−52

2010.07.03

TDS01V評価キットでデータ取り

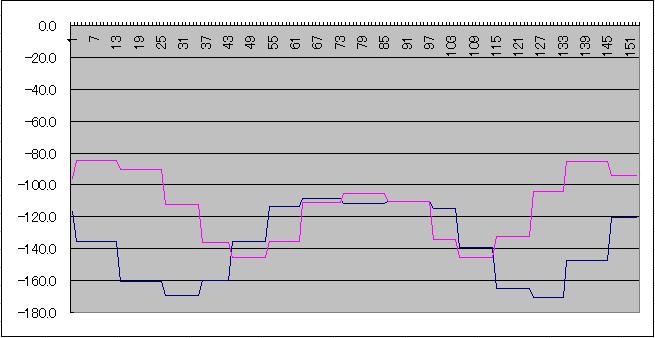

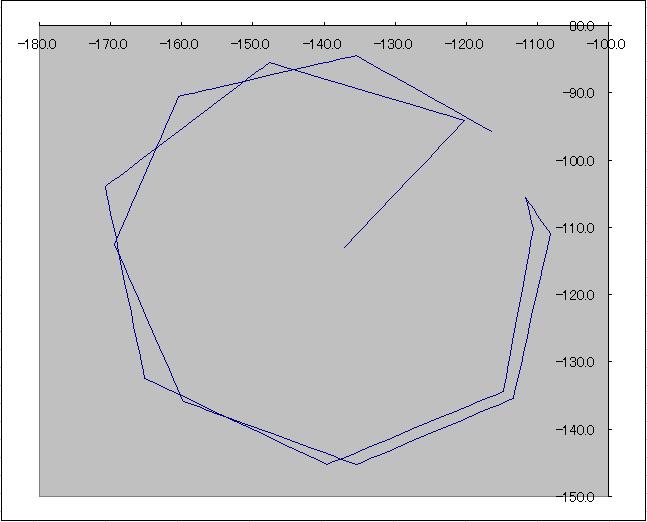

いつもの公園で、測地データと磁気ベクトルデータを同時に記録しみました。浅い地中に

金属や電線が埋まっていたりが無さそうな場所で8の字に走行し、水平方向の磁場の計測データ

をみて見ました。測ってみた数値をみたところ、どうも怪しい感じでした。プログラムを

見直したところ、通信で受け取ったデータを10進数に変換するところで、読む桁がずれていました。

これを直したら、それらしくなりました。

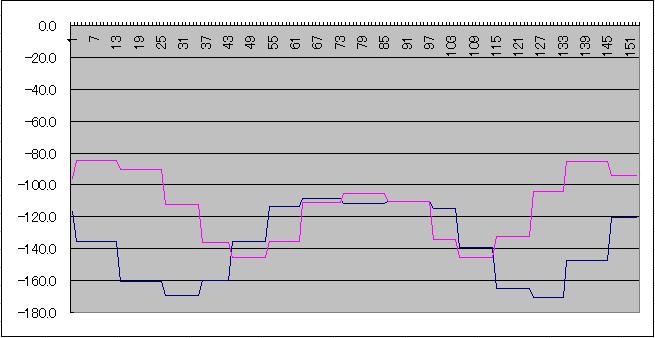

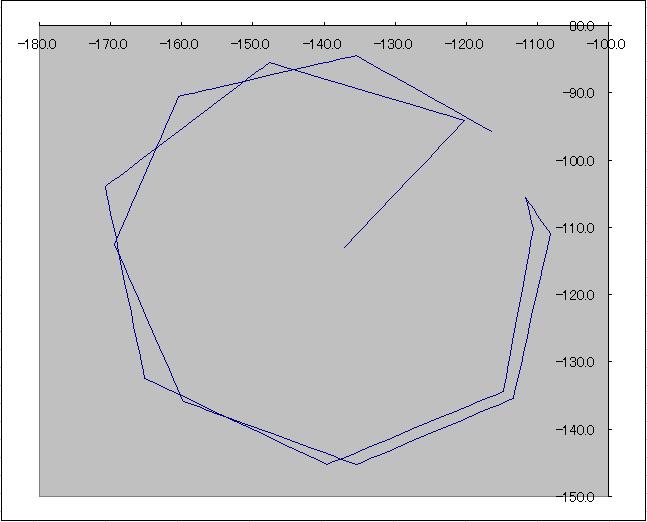

8の字走行なので、期待通りならば、X軸とY軸のデータは2重の円としてグラフに描き出されるはずです。

データの桁数が大きい(16bit)なので、精度も高いのかと思っていましたが、測定結果は

以下のようなグラフになりました。読取ルーチンをGPSのスレッドに混ぜた

都合、通信間隔は2秒おきですが同じデータが続く部分が多いためグラフがカクカクしています。

X軸、Y軸を独立してプロット

X軸、Y軸を合成してプロット

データシートを改めて読み直してみると、磁気センサの方位精度は±10度でした。してみると

チップの性能どおりのデータを受け取れているとも思えました。・・・がっかりorz

Cds(光センサ)取付け

Webカメラからは自動露出で、周囲の明るさにあまり影響を受けずに同じような明るさの

画像が入ってくるため、実際の周囲の明るさの目安を得るためCdsセンサを取り付けました。

(当初から回路図には書いてあり、マイコン周囲の配線やI/Oルーチンも実装済みでしたが

センサ本体が未取付けでした。)

Cdsの取り付け状態

2010.06.20

TDS01V評価キットとの通信機能追加

3D磁気センサの機能を利用するためのコマンドとデータの送受信機能の追加を終えました。

地磁気の強さは40μT程度のようですが、試しに普段ロボットを作っている、PCを

載せた机周辺で計測してみると地磁気の10〜100倍の磁気がありました。

机の周囲で方位磁針がクルクル回るわけだと納得しました。

それらしい数値が入ってくるようになったので、同様のコードをGPSからのデータを

読み取るスレッドに組み込みました。近々にいつもの公園で、測地データと磁気ベクトルデータ

を同時に記録し、どの程度地磁気以外の磁気があるのか見てみようと思います。

2010.06.13

PSoCを使う練習(I2C)

動きを知っているものをつないで練習ということでRTC-8564NBをブレッドボードエリアに

セットし、I2C ハードウェアブロックのデータシートを読み始めました。

TDS01V評価キット

主に3D地磁気センサ機能を使うために搭載しようとしています。キット付属の

「ソフトウェア開発者ガイド」を読みながら、制御ソフト(w7b)にキットと

通信する機能追加を始めました。てっきりバイナリデータで通信するのかと思って

プログラミングを始めたら、キャラクタデータ+改行コードの形でコマンドを送る

仕組みだったので、気がつくまで若干はまりました。

2010.06.06

PSoCを使う練習(カウンタ)

今週は、現在センサヘッドに付いている超音波距離センサ(LV-MaxSonar EZ1)を、センサヘッド内に搭載予定の

PSoC CY8C29466-24PXIの方に移植するため、PSoC Evaluation Kitで練習しました。主に16bitカウンタについて

試行錯誤しました。

PSoC Evaluation Kit

マイコン増設にあたり、この先センサ増設時の柔軟性やロボット運用のし易さなどの面から考えて、

USB−シリアル変換チップ経由で、直にPCと通信するのが良いか、既に搭載しているH8マイコン

からI2Cバスを伸ばして通信するのが良いか検討中です。

2010.05.30

サンプルデータ取り

公園の歩道、歩いている人、路肩の白線、明るさの変化が激しい場所・・・などなど、ロボットを

リモコン操縦で走らせながら、QCamに付属のユーティリティーソフトで30分ほどのサンプル動画データ

を撮影してきました。ついでに、録画中はGPSのログもとりました。木が生い茂っている場所や、

ビルの傍など、動画とGPSのタイムスタンプを付き合わせながら、どういう場所で、どの程度の

受信状態になるのかをじっくりみてみる予定です。動画など、比較的容量の大きなデータを簡単に扱えるので、

PCで制御するロボットは便利で良いな〜と思いました。

マイコン追加

センサーヘッドにセンサーを追加するにあたり、現状搭載しているマイコンボードがロボットの

最下部にあり、個別に配線すると、遠くて途中の配線が邪魔になるので、センサーヘッドの中にもマイコンを追加しようと

検討を始めました。2005年に購入したものの、転職と引越しのゴタゴタでなんとなく死蔵状態

だったPSoC Evaluation Kitを引っ張り出して使い始めました。

2008年に今メインで使っているVistaのPCでも使えるように、Programmerなど関連ソフトを

インストールすると共に、ライターのファームもアップデートしておいたのですが、最新版のソフトが

使えるようだったので、新しい物をインストールしました。

アナログブロックの使い方がピンと来ていないのですが、Webで公開されている情報や、メーカーの

サンプル類を適当に真似ているうちに、CdsからのデータをPCまで持ってくることは出来ました。

以前の簡単なテストでは、GPSレシーバーへの

干渉も少なかったので、このマイコン(CY8C29466-24PXI)を使う方向で進めようと思いました。

PSoC Evaluation Kit

2010.05.23

新しいカメラ

いくらも使っていないのですが、2個買ってあったQCAM7500Sの一つの調子が悪くなってしまいました。

2個そろっていないとステレオビジョンに都合が悪いのですが、同機種は既に販売終了の様でした。

すぐに壊れてしまったのと同系統のカメラを買うのはあまり気が進みませんでしたが、ロボット側のマウントを

作り変えなくとも使えそうなロジクールC500を、スペアも含めて3個購入しました。

(値段は1個約3000円でした)

新しいWebカメラ

ピントを手動で合わせる必用が無くなる等、光学系の仕様が若干違いましたが、マウントやアプリケーション

ソフト等を変えずに使用できました。また、少し使ってみた感じでは、画角やダイナミックレンジも

大体同じくらいに感じました。

ちなみに不調になったQCAM7500Sの症状ですが、使い始めて数分たつとカメラからの画像更新に

非常に時間がかかるようになり、画面の中央付近から、途中の何ラインかがスキップされるような感じで

上下の画像が若干ずれます。表示ルーチンでアドレス

計算を間違えて時の表示みたいでした。なので初めはソフトを疑ったのですが、他のハードでは

問題ないので、故障と結論しました。

2010.05.09

コーンの画像処理(追跡機能の強化)

2010.04.25の更新で触れたソフトを別のシーンで試してみましたが、ほとんどうまく働きませんでした。

移動ロボットの視覚として利用する中で、対象を認識させようとした場合、イメージの拡大・縮小に

対応する必要性を実感しました。前回のサンプルイメージの例では、コーン側面の濃淡が、距離によって

見え方があまり見え方が変わらないのが比較的うまくいっていた理由で、別のシーンで、たとえば50m

ほど離れて立っている木に近づいてゆくシーンでうまくいかない理由でした。

そこで、簡単にできる機能追加として、色の特徴でフィルタをかけたイメージの中から対象を切り出し、

検出窓の大きさにイメージを拡大縮小してからCogniMemにかける方針に変更しました。

下の動画では次のようなステップで各フレームの画像を処理しています。

1.赤いピクセルを白に、他を黒に(赤かどうかはRGB空間で正規化したベクトル間のなす角度で判定)

2.画像カラータイプ変更 カラー → グレースケール

3.画像サイズ変更 640×480 → 320×240

4.W6用の画像処理関数を使うためイメージフォーマットをOpenCVのIplImageからW6のフォーマットに変換

5.ノイズ除去その1(2ピクセル以下で独立したエリアをノイズとして消去)

6.残ったエリアにインデックスを付け、それぞれの面積や重心位置などを計算

7.ノイズ除去その2(面積が64ピクセル未満のエリアを消去)

8.表示用イメージ作成(W6のフォーマットからIplImageに変換)

(インデックス済みエリアの拡大・縮小以降は作成中)

実際やってみると、光源(木の間から見える空)の周りにWebカメラのレンズの色収差のためか、

青や赤の色が出て、実際にはコーンに似た色がそのシーンに無いのに上記ステップ1を通り抜けてくる

ピクセルが大量にあったり、サンプルで使ったコーンに光沢があるため、周囲の映り込みから、「赤」

の幅がけっこう広かったりすることが分かりました。

こんな感じで1枚の画像だけでは情報を取れない場合が多かったですが、自機の絶対位置の誤差が

蓄積しない性質があるGPSを装備した移動ロボットから、移動しつつ別の方向から撮影したイメージ

で補うと、画像認識の難しさを減らせる方向に持っていけそうな気がしました。

2010.04.25

追跡機能のテスト

前回の更新の時に考えたように、ココと認識した場所を学習させて様子を見てみました。

1度外れた場所を「コーン」として学習してしまうとニューラルネットワークが正しく働かなくなってしまい、

良い結果は得られませんでした。

「コーン」として、イメージの中で学習させる部分を工夫しつつ、見失った時に今までイメージの中で

コーンが移動した方向から計算して、そちらの方向へ検出窓を移動させてみたところ、このサンプル

ではそれらしく追跡するようになりました。

ちなみに学習させた場所は、コーンの日向と日陰の境界辺りで、学習対象枠に背景が入らないように気をつけました。

また、640×400、30pfsで撮影した動画を5フレーム毎にbmpファイルに変換して使用しました

2010.04.11

追跡機能のテスト

2010.02.07に撮影したサンプル画像から作ったBMPファイル集を順番に表示する機能を

付けたので、その中に写っている赤いコーンを、今の追跡機能でどの程度追えるか様子を

みてみました。

サンプル画像ではコーンに近づいてゆくため、初めのフレームで学習した対象がだんだん大きく

なります。現状では特にターゲットサイズ変化の考慮をしていないので、すぐにロックオン

が外れることを確認できました。

つぎは簡単な対策として、学習結果の更新動作を入れてみようと思いました。

サンプル画像

2010.03.22

動画環境整備

あらかじめ撮影しておいた動画を、あとでゆっくりと追跡機能にかけて様子をみるため、

動画の各フレームをBMPファイルに変換することと、追跡の結果などを集めて動画に

戻す環境を整備しました。(具体的にはVistaのムービーメーカを試したり、フリーソフトを

試したりしました。)

シリアル通信の速度アップ調査

マイコンとCogniMemの間は400kHzのI2Cで結んでいるので、PCとマイコンの間のシリアル

通信の速度を上げれば、認識処理のサイクルをまだ短く出来ます。そこで、簡単な設定変更で

どの程度上げられるのか試してみました。

今使っているPCのマザーボード上のCOM1は、SerialPortコントロールにRS232規格の系列以外の

通信速度をセットするとエラーになりました。マイコン側で誤差少なく設定できる通信速度

の57600bpsが限度のようだったので57600bpsを使うことにしました。

マニュアルによるとこのエラーはPCのCOMポート用ドライバの制限による

とのことだったので、アースローバーに載せてあるUSB−シリアル変換基板

(FT2232D USB−シリアル2ch変換モジュール)経由も試してみることとしました。

こちらは例えばマイコン側の上限である500000bps等を設定してもエラーにはなりませんでした。

でも比較のため57600bpsで認識処理をさせてみたところCOM1に比べて非常に時間がかかることが

分かりました。どうも、このモジュールのデフォルト状態では、各転送バイト間で長時間待たされてしまう

設定のようでした。

2010.03.14

追跡機能のデモ

2010.03.07

追跡機能の試作

あらかじめカテゴリーと追尾開始場所(そのカテゴリーのものが写っている場所)を指示した後、

追尾する機能を試作しました。アルゴリズムは前回のループで対象を見つけた場所の上下左右数ピクセル離れた場所

のイメージをCogniMemにかけ、チップが返す距離値が一番小さい場所を今回の場所として処理を続けてゆくものです。

2/21の所で触れたように、1秒間に処理できる回数が低いので、机の上のカタツムリくらいしか

追跡できませんが、仕組みとしては使えそうな感じがしました。

次は対象の向きや、照明条件が途中で変わるケースなどに対応するため、随時学習処理を入れ、試してみようと思います。

CUDAの環境設定(続き)

先週はベンチマーク的な、グラフィックを使わないサンプルをビルドしてみました。続いて

N−Body等、グラフィック有りのサンプルをビルドしてみました。Visual C++の環境で、

適当にPlatform SDK等まで含めてパスを通し、通したつもりが読み込まれないヘッダ、ライブラリ、dll

(OpenGL関係でエラーが出ました)は実行ディレクトリに直接コピーするなど、いじっているうちにビルドできるようになりました。

N−Bodyみたいなシミュレーションは、プログラミングの勉強を始めた頃(学生の頃)に

凝っていたことがあります。その頃はNEC PC−100のベーシックで、5個くらいの

質点を2Dで画面に描いて遊んでいました。8400GSはCUDAが使える一番性能の低い

GPUですが、計算結果を見て、あの頃と比べて「えらい処理能力だな〜」と感心しました。

2010.02.28

モード切替機能

CUDAのインストール

2010.02.21

画像の中をスキャンする機能

2010.02.14

CogniMem学習用ソフトの製作

2010.02.07

CogniMem学習用ソフトの製作

それぞれのレジスタにアクセスするためのクラス整備を終えて、表示されているイメージの

範囲を選んで学習用のベクトルデータを作る機能を作りました。

サンプル画像の撮影

2010.01.31

CogniMem学習用ソフトの製作

カメラの搭載

そろそろ、走行中のロボットから見たサンプル画像を撮ろうと、センサーヘッドにQCAM7500sを搭載しました。

とりあえず、USBハブをバスパワーで使うため、右側だけ搭載しました。左側を載せるのは、USBハブへの

電源ライン配線が終わった後です。

2010.01.24

CogniMem学習用ソフトの仕様検討

何かを認識させるためには、あらかじめ認識させたいもののパターンを学習させなければなりません。そこで、

改めてチップのマニュアルを読み直しながら学習用ソフトの仕様を検討しました。

とりあえずgeneral vision製の

Image Knowledge Builder

みたいなソフトが必用かな?と思いました。

平行して、チップに学習させる前段階の画像処理の参考に「顔認識」でヒットする文献に目を通しました。

あとは、アースローバーにどういう機能を付与するかを考えています。「見えている物に向かってまっすぐ走る機能」

(こういった機能をvisual servoingと言うようですね)や先日のコンテストで使った

「コーンを視野の中から探す機能」、そしてそれらの機能を統合して「GPSで決めたルートを辿りながら、途中で

見つけた空き缶を集めてゆく」みたいなのはどうかな?などと考えています。

2010.01.17

CogniMemアクセス用のソフト制作

かなりハマッた様な気もしますが、なんとか学習と認識の基本機能が使えるようになりました。

引っかかったのは以下の点でした。

- 初めに見た回路図と端子の表は電源の+−が逆に書かれていた。

→最新のドキュメントでは訂正されています。

- スレーブアドレスがわかりにくかった。

→I2Cアクセス手順の説明に2つアドレスが書いてあったのですが、はじめは関係ない方でアクセスしようとしていました。

- 1バイトのレジスタも2バイトアクセスする必要がある

→ComponentとLast Componentレジスタは上位バイトを0として2バイトアクセスしたら動きました。

超音波距離センサの屋外試験

Webカメラのセッティング

2010.01.11

超音波距離センサの機種変更

先日のGPSロボットカーコンテストで話を聞いて、良さそうだったのでLV-MaxSonar EZ1を

付けてみました。まだ少ししか動かしていませんが、20℃の部屋でも9℃のベランダでも

調子よく動作しました。

CogniMemアクセス用のソフト制作

アクセルコントロール機能の動画

前回作った機能の動画です。こんな感じで走ります。

2010.01.03

AKI H8/3052とGPSの干渉

アクセルコントロール機能の追加

PSD距離センサにシェード追加

太陽光が直接入射しにくいように、長さ5cmで長方形断面のシェード工作用紙で試作し、

外で走らせて試してみました。有効に機能したのでこのまま使いたいところですが、何かに

ぶつかった時などに容易に壊れてしまうため、そのうちシェードを含めて取り付け方法

を再設計しようと思いました。

製作日誌(その1)(2009/05/06〜2009/12/13)

戻る

−−>

−−>

−−>

−−>